创新工场成功的例子创新工场「数据下毒」论文入选NeurIPS 2019AI安全问题需要引起关注

雷锋网 AI 科技评论按:9 月 4 日,被誉为机器学习和神经网络领域的会议之一的 NeurIPS 2019 揭晓收录论文名单,创新工场人工智能工程院的论文《Learning to Confuse: Generating Training Time Adversarial Data with Auto-Encoder》(深度困惑:一种利用自编码器生成恶意训练样本的方法)被接收在列。这篇论文的三位作者为:冯霁(创新工场南京国际人工智能研究院执行院长)、蔡其志(创新工场南京国际人工智能研究院研究员) 、周志华(学人工智能学院院长)。

这篇论文围绕现阶段人工智能系统的安全性展开研究,具体而言,文章提出了一种高效生成对抗训练样本的方法 DeepConfuse,通过微弱扰动数据库的方式,彻底破坏对应的学习系统的性能,达到「数据下毒」的目的。这一技术的研究并不单单是为了揭示类似的 AI 入侵或攻击技术对系统安全的威胁,而是致力于在深入研究相关的入侵或攻击技术的基础上,有针对性地制定防范「AI 黑客」的完善方案,对 AI 安全攻防这一前沿研究方向的推动与发展具有积极指导作用。

NeurIPS,全称神经信息处理系统大会 (Conference and Workshop on Neural Information Processing Systems),自1987年诞生至今已有 32 年的历史,一直以来备受学术界和产业界的高度关注。该会议固定在每年的 12 月举行,由 NIPS 基金会主办。在中国计算机学会的国际学术会议排名中,NeurIPS 为人工智能领域的A类会议,同时也是人工智能领域最富盛名的年度会议之一,会议门票动辄在数分钟内售磬。

一直以来,NeurIPS 都以重视论文质量著称,并保持着相对较低的录取率。今年,NeurIPS 会议的论文投稿量再创造新高,共收到 6743 篇投稿,最终录取 1428 篇论文,录取率为 21.2%。

目前这篇论文还不是最终状态,Camera Ready 将版本在 1 个月后通过 NeurIPS 正式途径放出。下面我们介绍一下论文的主要内容。

近年来,机器学习热度不断攀升,并逐渐在不同应用领域解决各式各样的问题。不过,却很少有人意识到,其实机器学习本身也很容易受到攻击,模型并非想象中坚不可摧。

例如,在训练 (学习阶段) 或是预测 (推理阶段) 这两个过程中,机器学习模型就都有可能被对手攻击,而攻击的手段也是多种多样。创新工场 AI 工程院为此专门成立了 AI 安全实验室,针对人工智能系统的安全性,进行了深入对评估和研究。

《Learning to Confuse: Generating Training Time Adversarial Data with Auto-Encoder》这篇论文的主要贡献,就是提出了高效生成对抗训练数据的最先进方法之一—— DeepConfuse,通过劫持神经网络的训练过程,教会噪声生成器为训练样本添加一个有界的扰动,使得该训练样本训练得到的机器学习模型在面对测试样本时的泛化能力尽可能地差,非常巧妙地实现了「数据下毒」。

顾名思义,「数据下毒」即让训练数据「中毒」,具体的攻击策略是通过干扰模型的训练过程,对其完整性造成影响,进而让模型的后续预测过程出现偏差。(「数据下毒」与常见的「对抗样本攻击」是不同的攻击手段,存在于不同的威胁场景:前者通过修改训练数据让模型「中毒」,后者通过修改待测试的样本让模型「受骗」。)

举例来说,假如一家从事机器人视觉技术开发的公司希望训练机器人识别现实场景中的器物、人员、车辆等,却不慎被入侵者利用论文中提及的方法篡改了训练数据。研发人员在目视检查训练数据时,通常不会感知到异常(因为使数据「中毒」的噪音数据在图像层面很难被肉眼识别),训练过程也一如既往地顺利。但这时训练出来的深度学习模型在泛化能力上会大幅退化,用这样的模型驱动的机器人在真实场景中会彻底「懵圈」,陷入什么也认不出的尴尬境地。更有甚者,攻击者还可以精心调整「下毒」时所用的噪音数据,使得训练出来的机器人视觉模型「故意认错」某些东西,比如将障碍认成是通路,或将危险场景标记成安全场景等。

为了达成这一目的,这篇论文设计了一种可以生成对抗噪声的自编码器神经网络 DeepConfuse,通过观察一个假想分类器的训练过程更新自己的权重,产生「有毒性」的噪声,从而为「受害的」分类器带来最低下的泛化效率,而这个过程可以被归结为一个具有非线性等式约束的非凸优化问题。

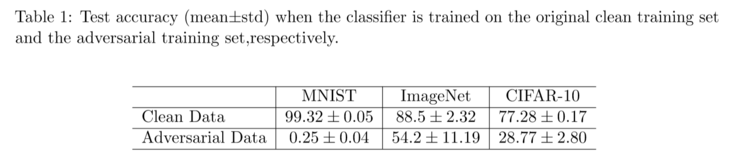

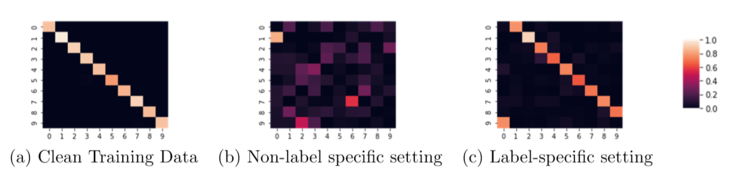

从实验数据可以发现,在 MNIST、CIFAR-10 以及缩减版的 IMAGENET 这些不同数据集上,使用「未被下毒」的训练数据集和「中毒」的训练数据集所训练的系统模型在分类精度上存在较大的差异,效果非常可观。

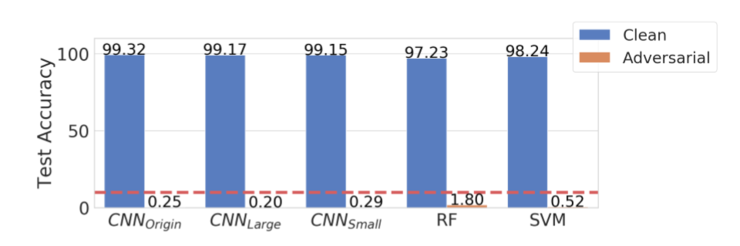

与此同时,从实验结果来看,该方法生成的对抗噪声具有通用性,即便是在随机森林和支持向量机这些非神经网络上也有较好表现。(其中蓝色为使用「未被下毒」的训练数据训练出的模型在泛化能力上的测试表现,橙色为使用「中毒」训练数据训练出的模型的在泛化能力上的测试表现)

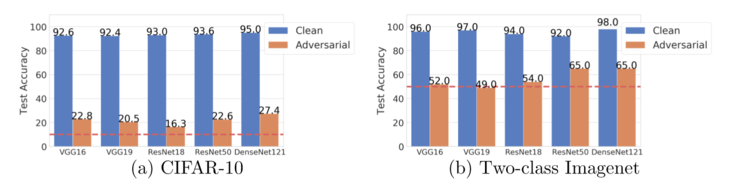

在 CIFAR 和 IMAGENET 数据集上的表现也具有相似效果,证明该方法所产生的对抗训练样本在不同的网络结构上具有很高的迁移能力。

此外,论文中提出的方法还能有效扩展至针对特定标签的情形下,即攻击者希望通过一些预先指定的规则使模型分类错误,例如将「猫」错误分类成「狗」,让模型按照攻击者计划,定向发生错误。

例如,下图为 MINIST 数据集上,不同场景下测试集上混淆矩阵的表现,分别为干净训练数据集、无特定标签的训练数据集、以及有特定标签的训练数据集。

实验结果有力证明了,为有特定标签的训练数据集做相应设置的有效性,未来有机会通过修改设置以实现更多特定的任务。

对数据「下毒」技术的研究并不单单是为了揭示类似的 AI 入侵或攻击技术对系统安全的威胁,更重要的是,只有深入研究相关的入侵或攻击技术,才能有针对性地制定防范「AI 黑客」的完善方案。随着 AI 算法、AI 系统在国计民生相关的领域逐渐得到普及与推广,科研人员必须透彻地掌握 AI 安全攻防的前沿技术,并有针对性地为自动驾驶、AI 辅助医疗、AI 辅助投资等涉及生命安全、财富安全的领域研发最有效的防护手段。

除了安全问题之外,人工智能应用的数据隐私问题,也是创新工场AI安全实验室重点关注的议题之一。 近年来,随着人工智能技术的高速发展,社会各界对隐私保护及数据安全的需求加强,联邦学习技术应运而生,并开始越来越多地受到学术界和工业界的关注。

具体而言,联邦学习系统是一个分布式的具有多个参与者的机器学习框架,每一个联邦学习的参与者不需要与其余几方共享自己的训练数据,但仍然能利用其余几方参与者提供的信息更好的训练联合模型。换言之,各方可以在在不共享数据的情况下,共享数据产生的知识,达到共赢。

创新工场 AI 工程院十分看好联邦学习技术的巨大应用潜力,今年3月,「数据下毒」论文作者、创新工场南京国际人工智能研究院执行院长冯霁代表创新工场当选为 IEEE 联邦学习标准制定委员会,着手推进制定 AI 协同及大数据安全领域首个国际标准。创新工场也将成为联邦学习这一技术「立法」的直接参与者。

9 月 5 日上午,创新工场 AI 工程院组织了一场问答,解答雷锋网 AI 科技评论等各家媒体提出的关于这篇「数据下毒」论文的问题。创新工场CTO、人工智能工程院执行院长王咏刚,以及这篇论文第一作者、创新工场南京国际人工智能研究院执行院长冯霁进行了在线解答。

王咏刚:这类似于网络安全工程师研究黑客入侵技术、攻击技术,只有对攻击技术有了全面充分的了解,才能制定有效的防范措施,开发相应的安全标准、安全工具。

冯霁:目的是对人工智能系统的安全性做一个技术性评估,假设数据库被恶意篡改的话,对应的系统会坏成什么样。这篇工作的另一个目的,也是希望呼吁引起对该问题的重视。

问:在这项研究中,先假定一个被攻击的模型,针对假定的模型就可以开始生成对抗性训练样本;而且这些生成的样本对于其他的模型也有明显的效果。也就是说,假如这个方法被实际使用,我甚至不需要知道别人使用的是什么样的模型就有机会对别人造成危害。我这样理解对吗?

王咏刚:目前的 AI 系统攻防处于非常早期的研发阶段,与传统安全领域已经相对成熟的方、算法、工具、平台等相比,AI 安全攻防还处于探索期。目前的主流攻击方法,如对抗样本攻击,数据下毒攻击等,虽然已经有一些防范思路,但无论是攻击技术,还是安全防护技术都在发展中。

冯霁:目前防护的技术还处于较为初期的情况,类似于网络安全,不存在一个包治百病的「疫苗」,对于人工智能企业,我们建议需要建立专门的安全团队,对自家的系统进行全方位的保护。

问:目前有没有利用这个方法实际去挖掘无人驾驶系统等领域的漏洞(类似科恩实验室成功攻击特斯拉系统那样)?

王咏刚:这个不算很难,其实有不少技术强的研究机构或实验室都可以做出类似的结果。可以说今天的很多无人驾驶系统使用的 AI 算法,在设计和实现的时候,是较少考虑安全防护的。另一方面,新的 AI 安全攻击方法、威胁形式也在不断涌现出来。黑盒模式在外部伪造交通标志进行攻击,白盒模式针对具体模型进行攻击,入侵模式针对数据进行「下毒」方式的数据污染,攻击方越来越多。我的感觉是目前业界对 AI 安全的整体认知和重视程度并不足够,这种情况下,一旦与人身安全或财产安全相关的 AI 系统大量上线运行,大量的安全事件就会暴露出来。我们建议尽早对 AI 安全防护进行透彻研究,尽早投入足够资源研发 AI 安全防护工具与防护技术。

冯霁:针对无人车的攻击是有的,但是目前公布出来的主要是产生对抗样本。数据下毒的工作刚推出来 24 小时,尚未见到应用。我们需要提醒这项技术的破坏性很大,请读者不要做违法犯罪的活动。

问:「数据下毒」给 AI 安全性带来警醒。目前,AI 技术已经在很多领域得到应用,这种应用是不是已经远远超前于 AI 技术安全性的研究?

冯霁:是的,像任何一个新的技术一样,目前的应用走在安全性前面,我们认为无论是 AI 安全,还是 AI 隐私保护,在未来将会受到比传统计算机安全更大的重视。

王咏刚:最近刚刚出现的利用 AI 模拟语音来钱财的案件,就是AI安全的相对严重的事件。AI 技术必然会被应用于各种核心业务领域,甚至涉及财产或生命安全(如医疗、自动驾驶、金融等),未来随着 AI 攻击技术的发展,相关的事件必然越来越多。

冯霁:目前安全事件还不像传统计算机系统的病毒一样普遍,但是有理由相信,随着时间的推移,未来这件将会成为一个独立的产业,另外,针对安全或数据隐私的法律也会逐步出台,例如欧盟的 GDPR 法案。

冯霁:我认为AI系统的安全性和隐私性保证,是人工智能发展的必经之路。类似于计算机网络/计算机系统发展初期,当时病毒不多,但是随着时间的推移,必将催生出一系列的AI安全产业。我们认为,AI安全的威胁,要比目前的计算机病毒严重得多。

王咏刚:AI 安全性的理论研究层面:国内和国际的差距不大,国内如学周志华团队,在机器学习鲁棒性、安全性的核心理论层面,就有着非常前沿的研究成果。

AI 安全性的工程应用层面:应该说国内、国际目前都处于非常早期的阶段。从使用系统角度将,Google、Facebook 等巨头在工程、产品和系统里的AI安全技术使用上,有一定先发优势,比如 Google 已经在好几个具体的客户端、服务端产品中应用了联邦学习等保护数据安全的技术。但是随着国内对 AI 安全的逐渐重视,相信国内的应用级研发也会慢慢跟上来。

冯霁:目前 AI 安全性的研究十分新颖,大家几乎在同一个起跑线上,具体体现是最前沿技术的研制,中美平分秋色。我们认为安全无小事,国家需要重视。

王咏刚:不谈具体 ZAO 的问题。但本质上这一类问题是在发展和利用 AI 技术的时候,如何保护知识产权、用户隐私的综合问题。今天的 AI 技术发展必须考虑法律和道德合规性的问题,不能触犯用户底线,就像在欧洲做 AI 就必须符合 GDPR 规范一样。AI 安全攻防相关的技术可以为法律和道德合规性提供足够的技术保障,但这仅仅是技术层面的事情。人工智能安全,事实上必须由技术手段、法律手段、道德手段、行业规范手段等一起来维护。

冯霁:对于用户隐私数据造成的安全威胁,在人工智能时代将会被越来越重视,产生的威胁也会越来越多,ZAO 就是一例。联邦学习技术其实就是为解决此类问题提出的解决之道。类似于安全领域的「白帽子」,我们呼吁更多的 AI 安全「白帽子」的出现,共同对人工智能系统的安全漏洞进行评估和分析。

王咏刚:是的,人工智能领域不但有可能,也完全应该建立一系列行业安全标准,来规范人工智能技术的使用。这些安全标准可能包括:AI 系统鲁棒性和安全性的评估标准,AI 系统交换数据时的数据安全标准,AI系统涉及用户隐私数据时的隐私保护标准,AI 系统涉及人身安全时的强制性行业标准等等。创新工场AI工程院目前参加的 IEEE 联邦学习标准委员会,就是 AI 数据和隐私安全的标准之一。

冯霁:目前正在做,包括针对用户数据隐私保护的技术联邦学习,是 IEEE 推出的第一个人工智能协同合作方面的国际标准,创新工场正是负责其中的安全评估部分。

创新工场凭借独特的 VC+AI(风险投资与AI研发相结合)的架构,致力于扮演前沿科研与AI商业化之间的桥梁角色。创新工场 2019 年广泛开展科研合作,与其他国际科研机构合作的论文在多项国际会议中崭露头角,除上述介绍的「数据下毒」论文入选 NeurlPS 之外,还有 8 篇收录至五大学术顶会。

ICCV,全称国际计算机视觉大会( IEEE International Conference on Computer Vision),由IEEE主办,与计算机视觉模式识别会议(CVPR)和欧洲计算机视觉会议(ECCV)并称计算机视觉方向的三大会议,在业内具有极高的评价。

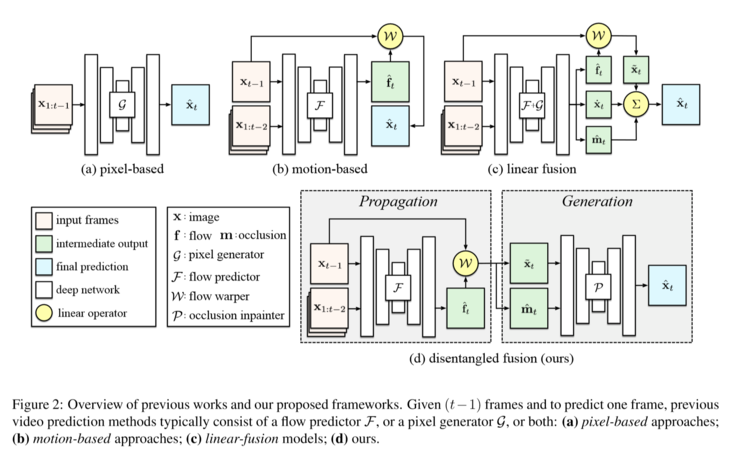

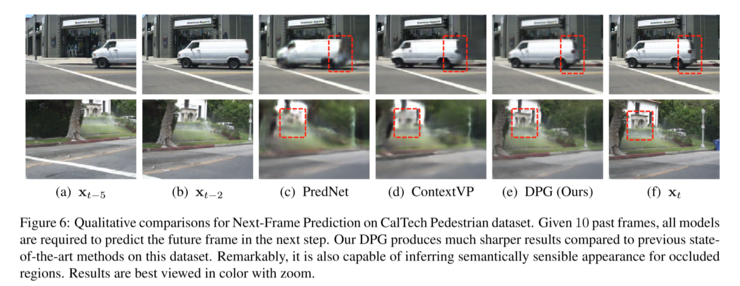

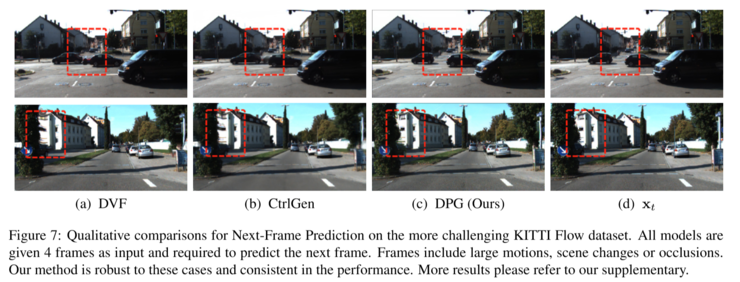

这篇论文的主要工作围绕一个视频预测的任务展开,即在一个视频中,给定前几帧的图片预测接下来的一帧或多帧的图片。

视频中的动态场景可以被划分成以下两种情况:第一种是移动相对平滑的画面,它们可以通过上一帧的画面使用比较简单的预测方式得到;第二种是有遮挡发生,通常难以直接通过外插得到的画面。此前关于这类视频预测的工作,只能考虑对之前图片的外插,或是使所有像素均由生成模型得到。

本文提出了一种组合式的模型来完成该任务,将视频预测任务解耦成运动相关的图片传播和运动无关的图片生成两个任务,并分别通过光流预测和图片生成的方法完成这两个任务,最后提出了一个基于置信度的图片转换算子将这两个操作融合起来。

实验证明,在动画场景和真实场景下,论文提出的方法都能产生更加精确的遮挡区域和更加锐利和真实的图片。

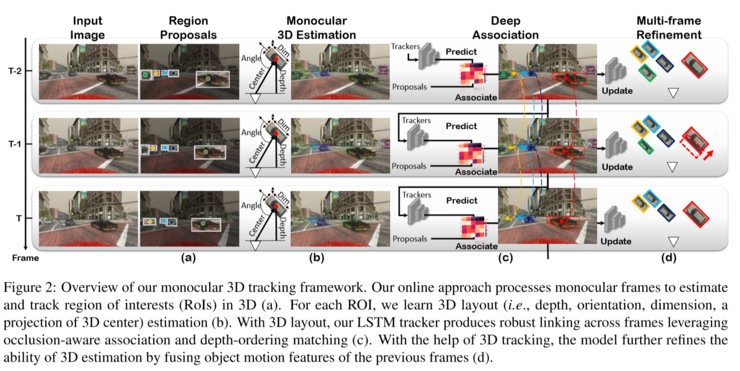

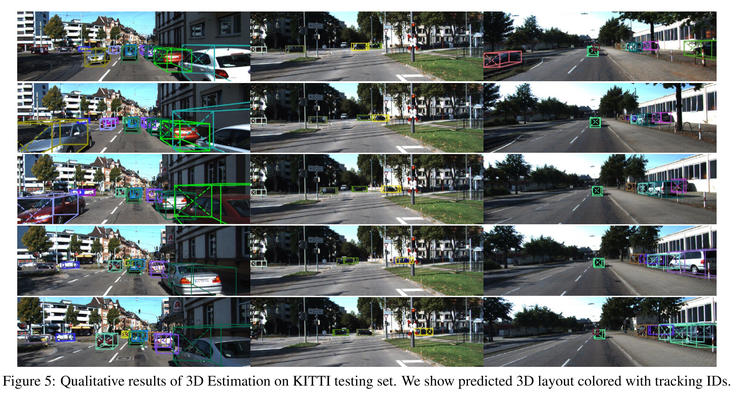

这篇论文提出了一种全新的在线三维车辆检测与跟踪的联合框架,不仅能随着时间关联车辆的检测结果,同时可以利用单目摄像机获取的二维移动信息估计三维的车辆信息。

在此基础上,论文还提出了基于深度的三维检测框匹配方法,并利用三维轨迹预测对遮挡目标进行重识别,该方法能够利用三维信息做到更加鲁棒的轨迹跟踪。

基于模拟数据,KITTI和Argoverse数据集的实验验证了该方法的鲁棒性。同时发现,在Argoverse数据集上,对30m以内的物体,仅使用视觉输入的方法的性能显著优于基于激光雷达输入的基线、一篇论文入选机器人与自动化领域国际顶会IROS

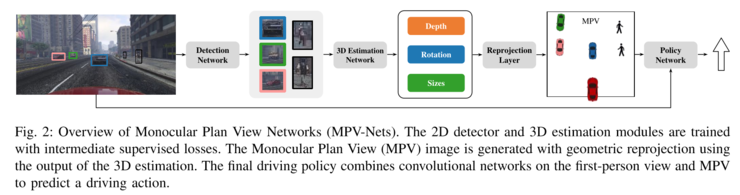

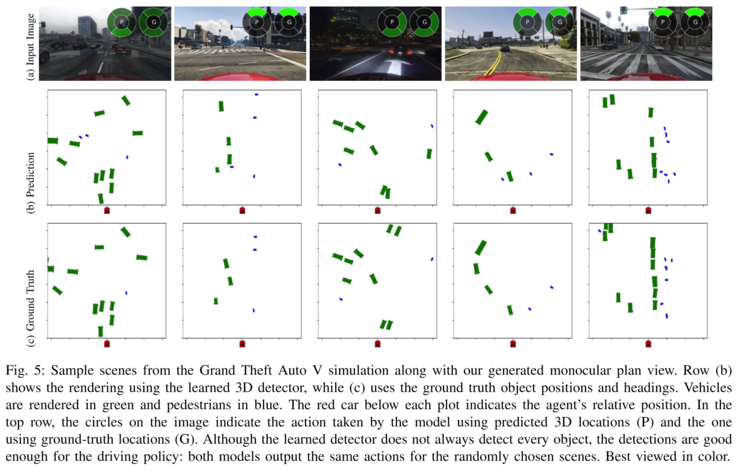

通常情况下,在单目视频上的卷积神经网络方法能够有效的捕获图片的空间信息,但是却对深度信息难以有效利用,这也是一直以来有待业内攻克的难点之一。

本文认为,这种人工设计的表征能够提供了一个对环境信息的抽象,使得神经网络能够更有效的推断物体的位置,朝向等信息。

可以说,文本表征一直是自然语言理解在深度学习时代的重要基础技术和前沿阵地。近年来预训练模型的广泛使用以及其在多数任务上的优良性能证明了其可以更好地表达一段文本在特定上下文中的语义。然而,作为语言表达的基本单元,词语一直是研究语义和理解的重要基础,尤其对于很多复杂场景中需要句法和各类关系信息的支撑,预训练模型也无法很好地表达这些文本中的词汇语义信息。

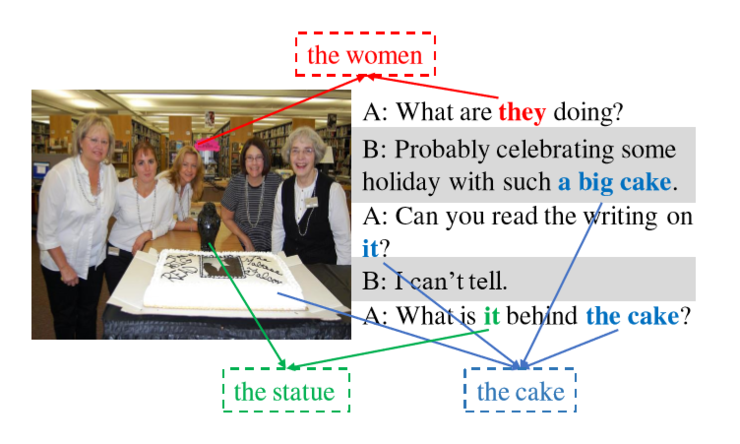

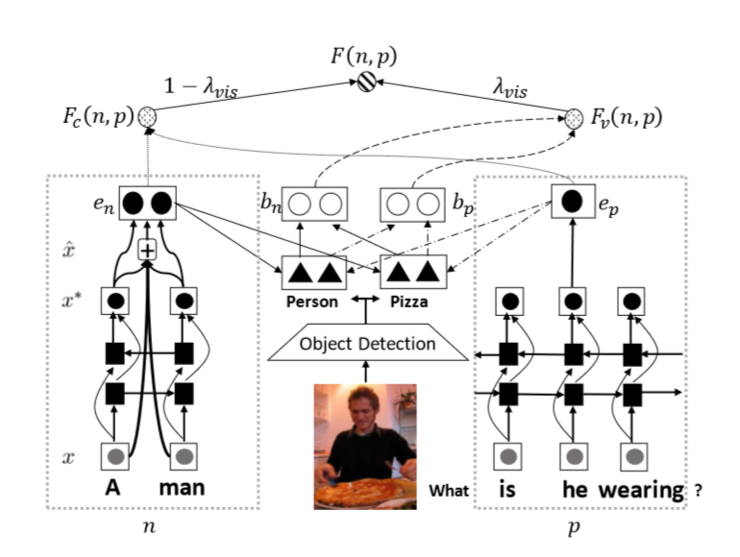

该现象给现有的指代消解模型带来了巨大的挑战,为此,本文提出了一个新模型(VisCoref)及一个配套数据集(VisPro),用以研究如何将代词指代与视觉信息进行整合。

其中,数据集部分,本文从一个含有视觉信息支撑的对线个对话,然后邀请众包平台上的标注者标注代词和它们指代的名词短语之间的关联关系,并经过一系列的清洗之后,得到了高质量的标注数据;模型部分,为了整合对话中的文字信息和图片中的信息,首先对于文字和图片进行信息抽取,并分别获得对应的向量表达,然后使用这些向量对于抽取的图像信息进行基于注意力机制的整合,并将得到的结果通过一个全连接神经网络预测基于视觉和文字的分数用于预测指代关系。

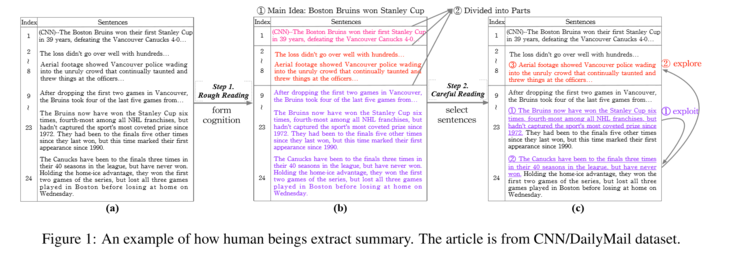

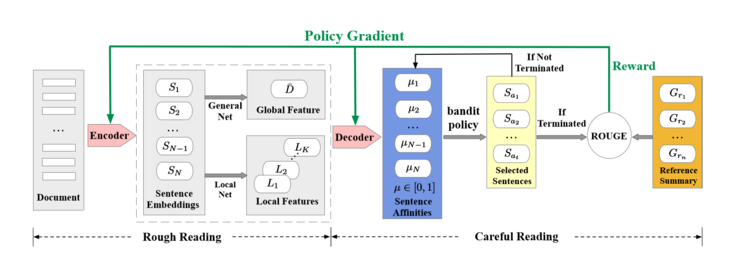

本文提出一种新的抽取式摘要方法来模拟以上两个阶段,该方法将文档抽取式摘要形式化为一个带有上下文的多臂老问题,并采用策略梯度方法来求解。

在CNN和DailyMail数据集上的实验表明,论文提出的方法不仅在ROUGE-1、2、L等度量上明显优于当前最好的抽取式摘要方法,并且能够抽取出具有不同长度的高质量摘要。

创新工场「VC+AI」模式的最独特之处在于,创新工场的 AI 工程院可以通过广泛的科研合作以及自身的科研团队,密切跟踪前沿科研领域里最有可能转变为未来商业价值的科研方向。这种「科研助推商业」的思路力图尽早发现有未来商业价值的学术研究,然后在保护各方知识产权和商业利益的前提下积极与相关科研方开展合作,同时由 AI 工程院的产品研发团队尝试该项技术在不同商业场景里可能的产品方向、研发产品原型,并由商务拓展团队推动产品在真实商业领域的落地测试,继而可以为创新工场的风险投资团队带来早期识别、投资高价值赛道的宝贵机会。

创新工场于 2016 年 9 月成立创新工场人工智能工程院,以「科研+工程实验室」模式,规划研发方向,组建研发团队。目前已经设有医疗 AI、机器人、机器学习理论、计算金融、计算机感知等面向前沿科技与应用方向的研发实验室,还先后设立了创新工场南京国际人工智能研究院、创新工场大湾区人工智能研究院,致力于培养人工智能高端科研与工程人才,研发以机器学习为核心的前沿人工智能技术,并同各行业领域相结合,为行业场景提供一流的产品和解决方案。

创新工场与国内外著名的科研机构广泛开展科研合作,例如,今年 3 月 20 日,香港科技大学和创新工场宣布成立计算机感知与智能控制联合实验室(Computer Perception and Intelligent Control Lab)。此外,创新工场也积极参与国际相关的技术标准制定工作。例如,今年 8 月,第 28 届国际人工智能联合会议(IJCAI)在中国澳门隆重举办,期间召开了 IEEE P3652.1(联邦学习基础架构与应用)标准工作组第三次会议。IEEE 联邦学习标准由微众银行发起,创新工场等数十家国际和国内科技公司参与,是国际上首个针对人工智能协同技术框架订立标准的项目。创新工场的科研团队深度参与到联邦学习标准的制定过程中,希望为 AI 技术在真实场景下的安全性、可用性以及保护数据安全、保护用户隐私贡献自己的力量。